智能时代,数据中心网络如何演进?

本站点使用Cookies,继续浏览表示您同意我们使用Cookies。Cookies和隐私政策>![]()

在数据中心内部,计算是“红花”, 数据中心网络 (Data Center Network,下称 DCN) 是“绿叶”。据 Amazon 数据中心统计,计算投资占比为 57%,DCN 的投资仅为 8%。数据中心正在从云时代向智能时代迈进,智能时代算力为本,通过优化网络性能来提升计算效率,带来数十倍的计算投资成本的节省,这成为 DCN 演进的主要驱动力。

作为 DCN 演进的主引擎,计算的变化将直接驱动 DCN 的发展。数据中心计算领域近年来呈现出三大变化方向:

• 计算接口高速化:阿姆达尔定律(Amdahl's lesser knownlaw)表明,并行计算中,每 1MHz 的 CPU 最大能产生 1Mbit/s的 IO。因此,一台有 32 核 2.5GHz 的 CPU 的服务器,则需要配置 100Gb/s 的网卡,才能将计算性能充分发挥出来。服务器上行对接 100GE 接入,400GE 核心转发成为越来越清晰的主流网络架构。

• 计算能力并行化:并行化是解决应用性能扩展的成功实践。随着用户数和数据规模增大,并行化程度越来越高。据Facebook 统计 , 用户在朋友圈一个“点赞”动作,会发起到数据中心 1KB 的 HTTP 请求,在数据中心内部,则放大为 930KB 的并行操作,包括 88 次 Cache 查找(648KB),35 次数据库查找(25.6KB)和 392 次后端 RPC 调用(257KB)。计算并行化,使得 DCN 内部流量(东西向)千倍增大,加剧网络拥塞,增加了通信时间,降低计算效率,智能无损网络的出现,是大势所趋。

• 计算资源虚拟化:1998 年,Greene(VMWARE 创始人)等发明了服务器虚拟化技术,通过把一个物理服务器虚拟为多个虚拟机,将计算资源的平均利用率从 10% 提升到 30%;而近几年新兴的容器技术(如 Docker,Kata,Unikernel),通过更轻量化的虚拟层技术,进一步提升计算资源的利用率。计算虚拟化带来的动态性,彻底改变了人管理网络的方式,驱动网络迈向自动驾驶。

计算领域的三大发展方向,正在引领着 DCN 发展趋势,特别是 AI 技术的广泛使用,一方面 AI 计算带来的千万级的迭代次数、高并行度以及海量参数传递,加剧了网络压力;另一方面应用 AI 技术实现网络的自我进化,以满足计算虚拟化的诉求,也带来了新的演进思路,必将触发新一轮变革。

处理器多核化以及 AI 处理器的普及,IO 带宽需求大幅增加。总线技术的发展,部分缓解了IO瓶颈。2020年,PCIe 4.0@16GT/s 开始商用,IO带宽达到 50Gb/s~100Gb/s甚至200Gb/s;2021年,PCIe5.0@32GT/s芯片也将发布,IO 带宽达到100 ~400 Gb/s。

网卡速率成为提升 IO 能力的又一关键。网卡从 10GE 演进到 25GE 乃至 100GE。配置 100GE网卡的服务器在 2020 年快速起量,成为主流。根据分析师机构 CREHAN 的预测,在 2020 年,100GE 网卡的发货量将超越 50GE 网卡,成为业界新的主流。

基于成本、功耗和生态考虑,DCN 或将跳过200GE,直接演进到 400GE。从历史实践看,服务器网卡和网络速率之比为 1:4,即 25GE 网卡对应 100GE 网络,100GE 网卡对应 400GE 网络;从光模块架构看,200GE 和 400GE 都采用 4-lane架构和 PAM4 调制方式,成本和功耗趋同,导致400GE 每比特成本相比 200GE 降低一半;从光模块生态看,400GE 模块种类更加丰富,给客户更多的选择。目前,200GE 的模块种类只有 100m-SR4和2km-FR4两种;400GE的模块种类达到了5种,涵盖 100m、500m和 2km。

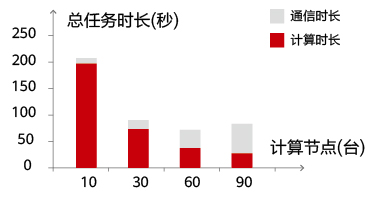

随着计算规模增大,任务总处理时间中通信时间占比持续增大,抵消了规模增长带来的收益,造成集群性能的负增长。如图所示,Netflix 的分布式电影评分推荐系统中,当计算规模达到90台,出现拐点,计算效率不升反降。

为了降低通信占比,降低应用等待时间,增大网络规模,无损网络是必经之路。

无损网络,最大化 25/100GE 高速接口传输效率

众所周知,应用之间通信需求是无损的。有两种实现方式:

•无损协议+有损网络: 在 10GE 网卡时代 ,一般采用这种方式 , 即网络可以在拥塞时丢包,在协议层进行补救,如在 TCP 协议上部署重传机制 , 在发现网络丢包后, 进行重传。

•有损协议+无损网络: 服务器网卡进入到25GE/100GE 时代,业界采用网卡硬化协议栈,解决协议处理消耗 CPU 过高的问题。为了硬化协议栈,协议必须简化,但这样一来又依赖网络的无损传输能力。据测算,采用实现 25~100Gb/s 带宽的满吞吐,需要消耗服务器 30% 左右的CPU;为了解决此问题,需要在智能网卡上硬件实现协议,硬件实现协议带来的好处是高性能。业界采用远端直接内存访问 (RDMA) 协议,替代复杂的 TCP 协议,便于网卡的硬化。RDMA 协议对丢包极其敏感,据微软实验室测试,2% 的网络丢包就会造成网络有效吞吐降到 0。所以,无损网络成为 DCN 的基本特征。

智能拥塞控制 + 智能流量调度 = 无损网络

• 无损网络,将重定义拥塞控制机制。拥塞控制,是通过网络和端点协作,控制入网流量速率,使得入网流量和网络带宽匹配,满而不溢。网络拥塞控制的准确性,对网络利用率影响很大。过早拥塞通知,将导致计算侧过度减速 , 网络利用率低。过晚拥塞通知,将导致网络过载而丢包。通过 AI 算法,预测流量模型,准确地通知计算侧,控制入网流量。网络还可以基于准确的活跃流统计 , 为每条流分配合适的速率 , 避免计算节点之间探测式发送,减少突发,从而减少网络的抖动。这种基于 Credit 的拥塞机制,特别适合存储等低抖动网络上。

• 无损网络,将重定义流量调度。在并行计算中,存在木桶效应,即最后完成的流,决定整个任务的完成时间。所以,对不同的流进行差异化的调度,降低整个任务的完成时间。在关键流或者 co-flow 识别上,AI 算法,可以发挥出重要的作用。

计算虚拟化,打破了服务器物理边界,计算资源可根据需求动态伸缩。SDN 的出现,是为了解决网络随计算而动的问题,即根据计算资源位置的变化,由 SDN 控制器动态为其构建一张逻辑网络,称为部署自动化。

SDN 部署自动化,大幅提升业务发放效率

部署自动化阶段,由原来的人 - 机接口,演进到机 - 机接口,配置效率百倍提升,从小时级到分钟级。

部署自动化的第一步是简化;如果在复杂的网络环境下部署自动化,会适得其反,让事情变得更复杂。业界在 SDN 的实践中也走过弯路,最终,遵循简化优选的原则,网络拓扑简化为Leaf/Spine,转发简化为 VXLAN,协议简化为 BGP-EVPN,网关简化为多活网关,为自动化打下坚实基础。

部署自动化的第二步是标准化;特别是 SDN 北向接口的标准化,让网络融入到云计算的生态中。Openstack 云平台成为主流,使得 Neutron 成为事实标准,加速 SDN 生态的成熟。

自动驾驶,实现全网络生命周期自治自愈

部署自动化也带来两大副作用:

• 高频度变更,使得配置错误存在放大效应:传统网络以天计的变更频度,让管理员有充裕的时间进行检查。但 SDN 以分钟计的高频变更,让一个小小的配置错误,都放大数百倍,成为潜在的隐患。据谷歌披露,数据中心网络中 68% 的故障是由于网络变更造成的。网络验证技术,在配置生效前,校验配置面的错误、冲突以及数据面的环路和黑洞等,可提前消除配置风险。

• 高频度变更,把运维时间压缩到分钟级:当网络瞬息万变,传统静态网络的运维方式都将失效。如何在几分钟之内,完成故障检测、定位和恢复,成为核心需求。

智能运维,基于海量数据采集和 AI 预测算法,一方面可提前预测并排除部分故障。另一方面 , 当故障发生时 , 采用融入专家经验的知识图谱,快速找到根因,为故障恢复提供依据。

自动驾驶网络,除了部署和运维的自动化,还包括规划自动化,建设自动化和网络自优化,即“规建维优”全生命周期自动化。

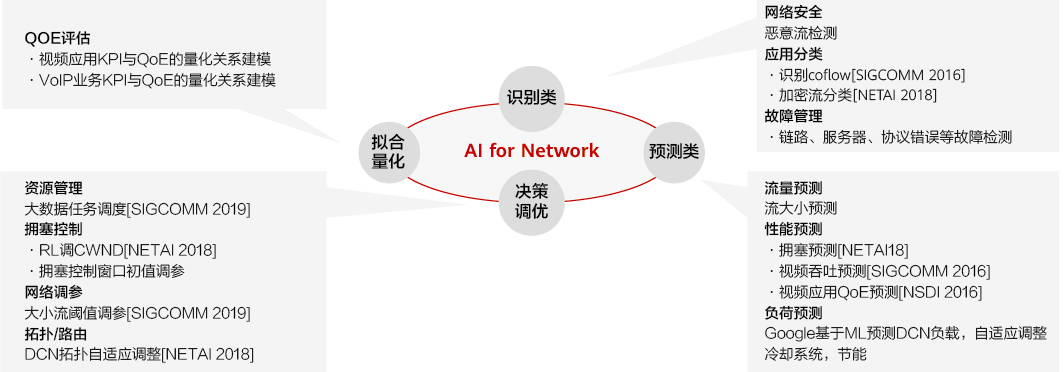

无论是智能无损还是自动驾驶网络,它的最终实现和落地离不开 AI 技术应用。没有 AI 算法的支撑,自动驾驶网络和智能无损将是空中楼阁。AI 算法在语音、语言处理、图像等领域获得了巨大的成功,将 AI 技术和网络结合 , 也将使得网络焕发青春。如下图所示,在识别、预测、调优和质量评估等方面,学术界和工业界都投入了巨大的研究热情,也初显成效。

华为正在携手学术界和产业界 , 持续挖掘 AI 能力 , 和网络技术充分结合,持续提升计算效率,一起迈向全新的 DCN 时代。